全流程直击大模型科学能力短板,司南上线科学智能评测体系 | AGI4S进行时

来源:上海人工智能实验室| 2026-02-13

人工智能驱动科学研究快速发展已成为全球共识。在AI for Science从1.0向2.0迭代演进的关键阶段,构建专业的科学智能评测体系尤为关键。

开源开放评测平台司南(OpenCompass)近日上线覆盖科研全流程的科学智能评测体系,包含科学场景、科学流程、评测基准、评测对象、评测工具及评测平台等六大核心模块,可支持多种大语言模型、科学专用模型以及多智能体相关评测。

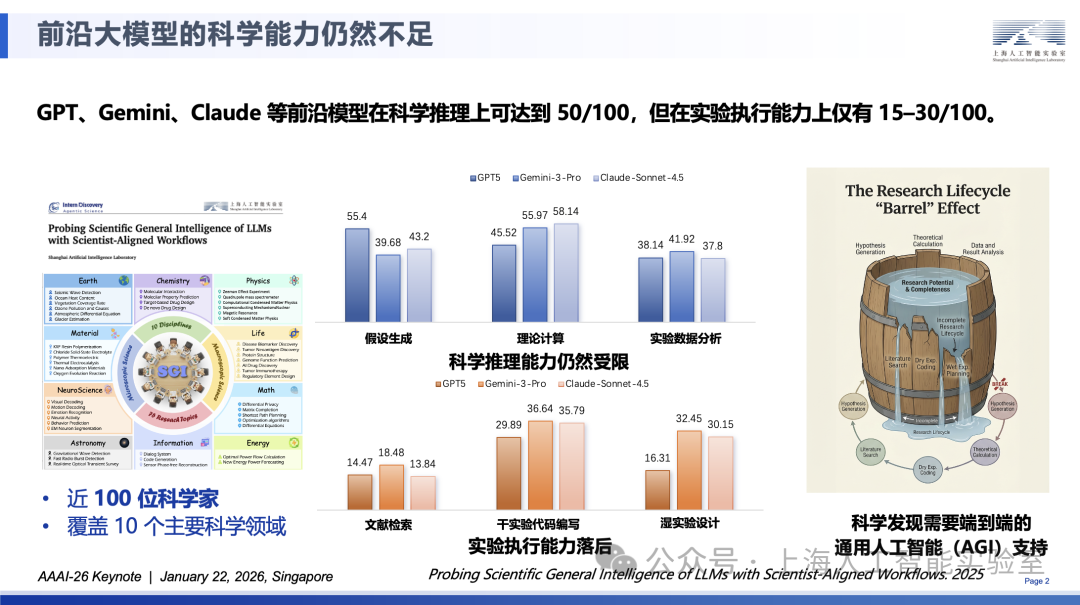

其中,上海人工智能实验室依托『书生』科学发现平台Intern-Discovery,联合十大科学领域近百位科学家,构建了面向AGI4S的科学通用智能评估基准SGI-Bench,结果显示,科学专业推理能力是前沿模型的短板①。基于上述基准,司南近期对国内外二十余款主流大模型开展系统性评测,并发布大语言模型、多模态模型科学能力榜单。

评测结果显示:

大部分模型缺乏将语言生成优势迁移至科学推理、符号操作与结构化理解任务的机制,科学能力呈现系统性缺口,模型在通用任务中得分接近上限,但在科学任务上普遍低于“通专均衡线”;

实验执行专业推理能力为最薄弱环节,制约了科学发现全周期效能——当前主流模型在通用科学推理任务中得分可达50分(满分100),但在各类实验执行专业推理能力中,得分骤降至15-30分;

为克服“木桶效应”,整合通用推理与专业能力,进而推动科学智能从AI4S向AGI4S迭代成为必然选择。

全链路解码AI科研能力

开源开放评测体系司南(OpenCompass)由上海人工智能实验室(上海AI实验室)打造,目前已从大模型评测扩展至科学智能、AI计算系统、具身智能、安全可信及垂类行业应用等六大领域,构建起“六位一体”的全景评估范式,覆盖从底层算力到上层智能的全链路关键能力评测,致力于为行业提供一站式、全景化的能力刻度。

新近上线的司南科学智能评测体系覆盖科研全流程,包含科学场景、科学流程、评测基准、评测对象、评测工具及评测平台等六大核心模块,支持多种大语言模型、科学专用模型以及多智能体相关评测。

司南科学智能评测体系六大核心模块

在科学场景方面,聚焦真实应用:针对科研中多学科、多模态的复杂需求,构建了统一语义空间的任务图谱,覆盖广泛的问题分布,包括物理系统建模、生命科学研究、化学反应和地球系统等多个重要科学场景,确立了以“问题驱动”为核心的能力测试原则。

在科学流程方面,还原科研链路:针对科研探索中的关键环节,构建了包含文献检索、假设生成、实验执行及结果分析的评测能力维度,实现对复杂科研任务的精细化拆解与子任务映射。

针对评测对象,统一语义框架:针对大语言模型、多模态模型及任务型智能体等多元对象,构建了标准化的输入输出接口与执行机制,确保不同类别的模型能在同一评测框架下进行公平的横向比对与纵向追踪。

在评测基准方面,深挖多维能力:针对文献调研、假设生成、实验执行及结果分析等核心流程进行基准化,构建了全方位评测矩阵,覆盖科学发现全流程(SGI-Bench①),从文档解析(ScienceMetaBench)、动态知识推理(EESE②),到假设生成(ResearchBench③),从干实验代码(SciCode④)到科学数据分析(SFE⑤)等具体步骤的评测维度,以及针对化学( ChemBench⑥)、凝聚态物理(CMPhysBench⑦)、地球科学(EarthSE⑧)、生命科学(Mol-Instruction⑨)、天文科学(AstroVisBench⑩)等多学科的学科评测基准。其中,SFE科学数据分析基准已被Seed、Intern等主流大模型用于多模态推理评测,为量化模型在高难度推理任务上的表现提供客观依据。

评测工具实现全自动化:针对评测流程的繁琐性构建了一套覆盖模型调度、任务生成、接口适配与指标计算的开源评测工具链(SciEvalKit⑪),实现了从输入基准数据到评测结果的全流程“一键执行”,为大规模、可复现的科学智能评测提供了基础设施支撑。

评测平台动态透明监测:针对科研单位与监管机构的评估需求,构建了具备可视化榜单、能力坐标系及时间序列分析的综合平台,支持对科学智能系统进行透明评估与动态监测。

科学发现亟需端到端AGI支持

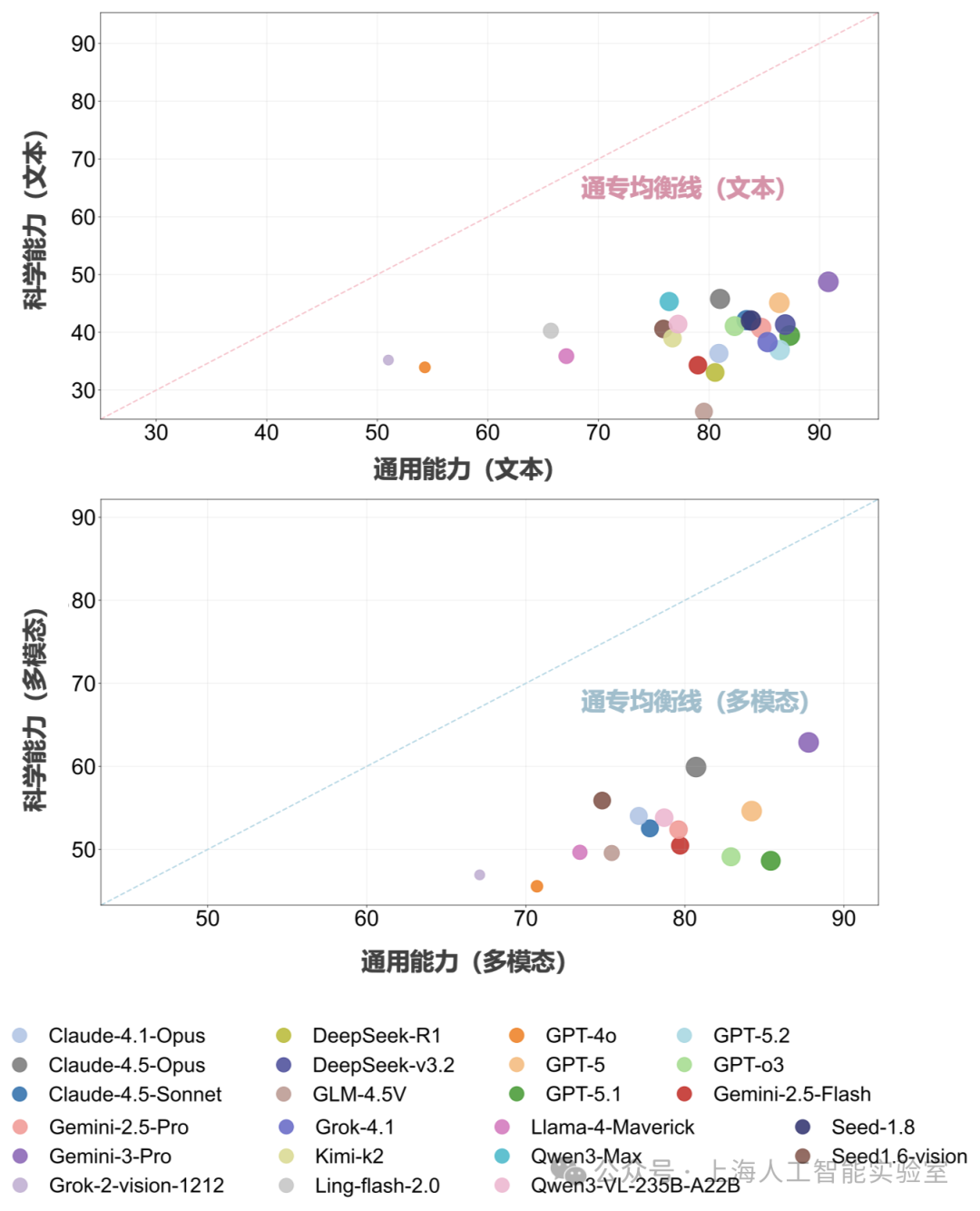

为了系统刻画大模型从通用智能向科学智能演进过程中的能力变化,科研团队构建了一个“通专能力坐标系”。通用能力指标基于当前主流的多学科问答基准(如MMMU与GPQA),用于衡量模型在跨学科知识理解等通用智能任务中的整体水平。专业能力指标则在SGI-Bench的基础上,集成了来自于Nature子刊和NeurIPS等AI顶级会议的科学评测基准,对标真实科研过程中的关键任务链路,划分成文献检索、假设生成、实验执行、结果分析等典型环节,并通过流程语义建模,支撑复杂科研任务的能力分解与子任务映射。

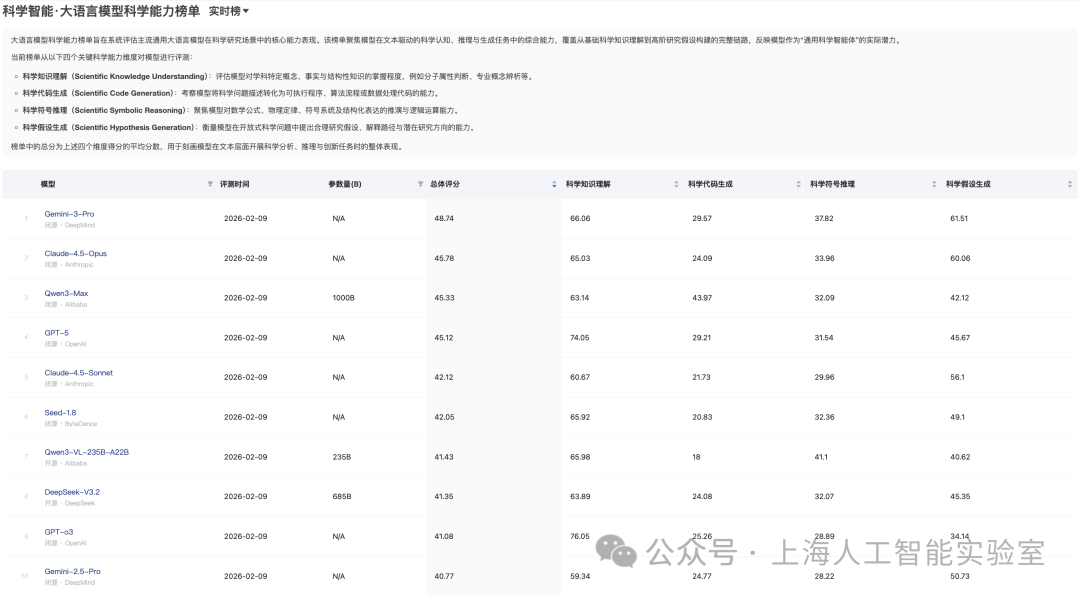

评测结果显示,当前主流大模型科学能力增速显著低于通用能力,大语言模型在知识理解方面已达及格线,但假设生成、代码生成则为明显短板;多模态大模型感知能力整体较好,理解及推理能力有限。

多数模型在通用任务中得分接近上限(超过80分),但在科学任务中整体处于50–60分区间,普遍低于“通专均衡线”。这一结论揭示当前大模型缺乏将语言生成优势迁移至科学推理、符号操作与结构化理解任务的机制,科学能力呈现系统性缺口。

语言模型的科学能力:知识理解>假设生成>代码生成

以前三名的大语言模型为例,国产大模型Qwen-3-Max与Gemini-3-Pro、Claude-4.5-Opus,在科学知识理解方面表现出了不错的效果(均超过60分),但在科学符号推理能力方面滑落到了40分左右。

在科学假设生成方面上,大部分模型可以获得做到50分的水平,Gemini-3-Pro甚至突破了60分,显示出了大模型做科学假设生成的潜力。

科学干实验代码推理能力则是最薄弱的环节——这也是导致“木桶效应”的重要原因之一。大部分模型的科学干实验代码生成能力处于20-30分区间;Qwen-3-Max在该指标获得最高分43分,领先第二名Gemini-3-Pro10分以上,显示出了国产模型在科学代码上的优势。

多模态科学模型感知能力整体较好,理解及推理能力有限

从多模态模型科学能力榜单前三名的表现来看,Gemini-3-Pro、Seed-1.6-vision和GPT-5虽未在单一维度上取得绝对最高分,但在感知、理解与推理三方面表现均衡,整体多模态能力排名居前,显示出跨模态信息整合与认知协同的重要性。而在单方面“偏科”的模型则难以扩展优势,如,Qwen3-VL-235B-A22B 在科学多模态感知维度上位列第一,表明其在科学数据的定位方面已达到领先水平,但其在科学多模态理解和推理上表现欠佳影响其整体表现。

这一现象表明,多模态科学智能的瓶颈并非仅限于“看得更清楚”,而在于如何将感知结果组织为可推理、可解释的科学推理逻辑。

综上所述,从数据的维度考察,当前的大模型更像“超级考生”,还未能成为独立探索未知的“科学家”。这也解释了为何大模型在传统评测基准中近乎满分,但往往在真实科研场景中却“不好用”。

司南科学智能评测通过对科学发现全流程进行模块化拆解,为大模型构建起“提出猜想-设计实验-分析数据-改进猜想”的全流程评估体系,力图让评测结果从更高维度客观揭示AI在科学发现路径上的进展与不足,从而推动大模型及智能体向真正具备科研能力的AGI进化。

参考文献

① Shanghai Artificial Intelligence Laboratory. Probing Scientific General Intelligence of LLMs with Scientist-Aligned Workflows [J]. arXiv preprint arXiv:2512.16969v1, 2025.

② Wang J, Zhang Z, Guo Y, et al. The ever-evolving science exam[J]. arXiv preprint arXiv:2507.16514, 2025.

③ Liu Y, Yang Z, Xie T, et al. Researchbench: Benchmarking llms in scientific discovery via inspiration-based task decomposition[J]. arXiv preprint arXiv:2503.21248, 2025.

④ Tian M, Gao L, Zhang S D, et al. Scicode: A research coding benchmark curated by scientists[J]. Advances in Neural Information Processing Systems, 2024, 37: 30624-30650.

⑤ Zhou Y, Wang Y, He X, et al. Scientists' First Exam: Probing Cognitive Abilities of MLLM via Perception, Understanding, and Reasoning[J]. arXiv preprint arXiv:2506.10521, 2025.

⑥ Mirza A, Alampara N, Kunchapu S, et al. A framework for evaluating the chemical knowledge and reasoning abilities of large language models against the expertise of chemists[J]. Nature Chemistry, 2025: 1-8.

⑦ Wang W, Huang D, Li J, et al. CMPhysBench: A Benchmark for Evaluating Large Language Models in Condensed Matter Physics[J]. arXiv preprint arXiv:2508.18124, 2025.

⑧ Xu W, Zhao X, Zhou Y, et al. EarthSE: A Benchmark Evaluating Earth Scientific Exploration Capability for Large Language Models[J]. arXiv preprint arXiv:2505.17139, 2025.

⑨ Cao H, Liu Z, Lu X, et al. Instructmol: Multi-modal integration for building a versatile and reliable molecular assistant in drug discovery[C]//Proceedings of the 31st International Conference on Computational Linguistics. 2025: 354-379.

⑩ Joseph S A, Husain S M, Offner S S R, et al. Astrovisbench: A code benchmark for scientific computing and visualization in astronomy[J]. arXiv preprint arXiv:2505.20538, 2025.

⑪ Wang Y, Chen Y, Li S, et al. SciEvalKit: An Open-source Evaluation Toolkit for Scientific General Intelligence[J]. arXiv preprint arXiv:2512.22334, 2025.