评测工具链SciEvalKit开源,用七大维度拆解AI的科学智商 | AGI4S进行时

来源:上海人工智能实验室| 2026-02-13

当前,通用大模型在对话交互、常识推理等领域已展现卓越能力。但面向更严谨、更复杂的科学领域,它是否依然“全知全能”?

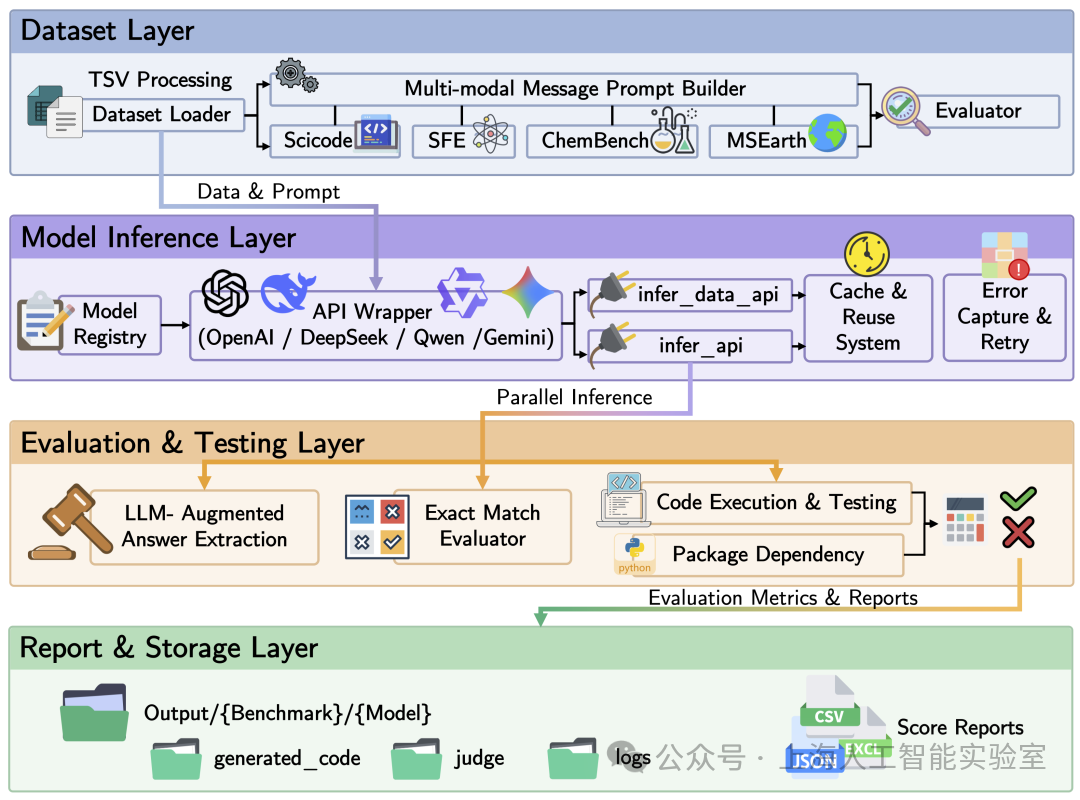

近日,上海人工智能实验室开源面向科学通用智能(Scientific General Intelligence)的评测工具链SciEvalKit。作为司南科学智能评测体系重要组成部分,SciEvalKit实现从输入基准数据到评测结果的全流程“一键执行”,为大规模、可复现的科学智能评测提供了基础设施支撑。

目前,SciEvalKit与集成至化学(ChemBench)、干实验代码(SciCode)、科学数据分析(SFE)及科学发现全流程(SGI-Bench)等高质量科学评测基准中,以全面衡量模型在多学科专业领域的深度推理与多模态理解能力。

技术报告:https://huggingface.co/papers/2512.22334

仓库链接:https://github.com/InternScience/SciEvalKit

科学智能评测榜单:https://opencompass.org.cn/Intern-Discovery-Eval/rank

重新定义AI的科学智商

现有评测往往局限于表面的正确性或狭窄的任务特定指标,无法评估大语言模型是否真正掌握了科学推理的全谱系。SciEvalKit的出现填补了这一空白。

SciEvalKit基于专家级科学基准构建,所有基准均来自真实世界的领域专用数据集,能够真实反映科学挑战,可跨多学科与多任务维度对AI模型进行评估。

SciEvalKit构建了灵活、可扩展的评测“流水线”,支持模型和数据集的批量评测、自定义集成,并提供透明、可复现的评测结果,致力于为下一代科学基础模型和智能体提供标准化度量衡。

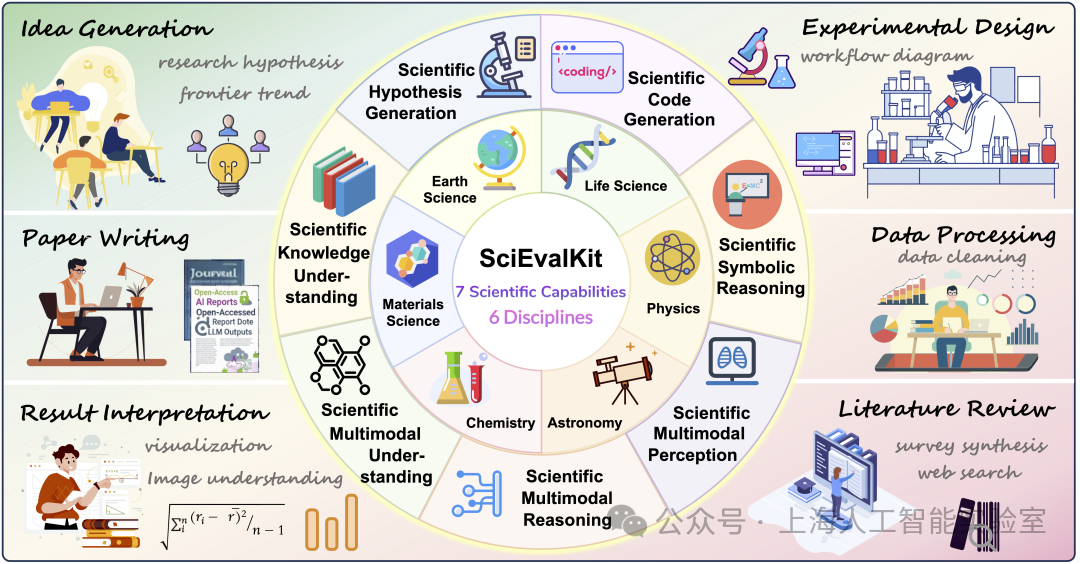

七大能力 x 六大学科,构建全维坐标系

为了全面诊断模型的“科学智商”,SciEvalKit构建了七大科学核心能力,覆盖六大科学学科的多维评估体系。

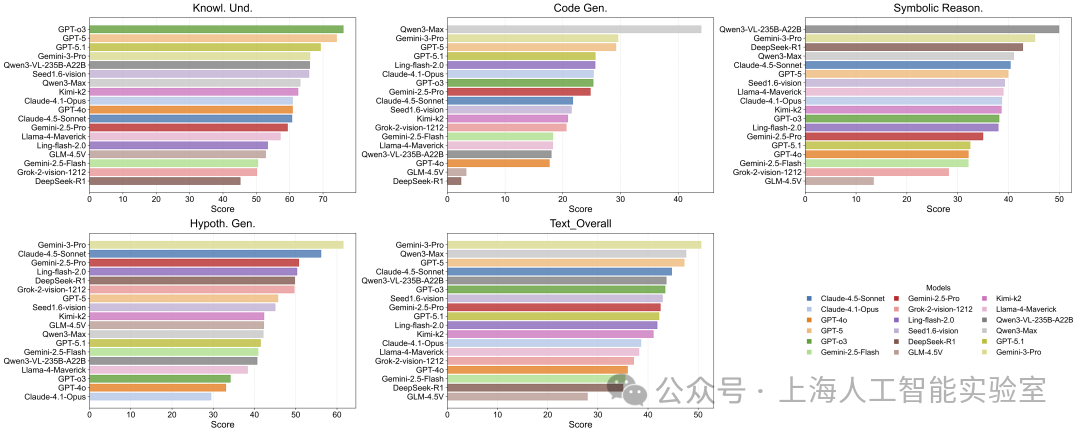

纵向深挖七大核心科学能力

从基础的知识理解,进阶到代码生成、符号推理、假设生成,再到复杂的多模态感知、推理与理解,涵盖了从“读论文”到“做研究”的完整链路。

· 科学知识理解 (Scientific Knowledge Understanding): 评估模型对领域特定概念和事实关系的掌握程度,例如分子性质预测。

· 科学代码生成 (Scientific Code Generation): 考察将科学描述转化为可执行逻辑和算法过程的能力。

· 科学符号推理 (Scientific Symbolic Reasoning): 聚焦于方程、物理定律、符号表达式及结构化符号的推演操作。

· 科学假设生成 (Scientific Hypothesis Generation): 衡量模型提出合理的科学假设和研究方向的能力。

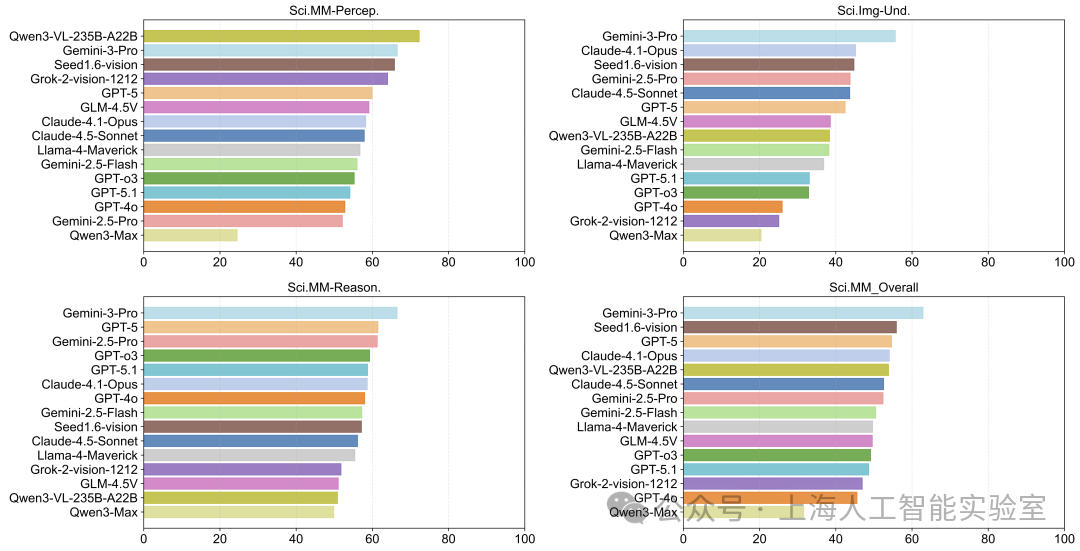

· 科学多模态感知 (Scientific Multimodal Perception): 关注在图文输入中对科学实体的定位与识别。

· 科学多模态推理 (Scientific Multimodal Reasoning): 涉及利用科研论文中的图像数据进行思维链(CoT)推理。

· 科学多模态理解 (Scientific Multimodal Understanding): 探索对原始科学数据的严谨解释能力。

横向覆盖六大科学学科

SciEvalKit 的评测范围包括物理、化学、材料、天文、地球、生命六大科学学科,每个学科的基准测试均经过领域专家的多轮咨询与校准,确保评测内容具备科学有效性与专家级水准。

SciEvalKit架构亮点

为了实现高效、可复现的科学评测,SciEvalKit采用了模块化的四层架构设计:

数据集层 (Dataset Layer): 处理数据摄入与任务规范,支持多模态提示词的构建。

模型推理层 (Model Inference Layer): 提供统一的 API 封装(支持 OpenAI, DeepSeek, Gemini 等)与本地推理支持,具备并行推理与容错机制 。

评测与测试层 (Evaluation & Testing Layer): 集成了基于规则的匹配、代码执行(Sandbox)以及 LLM-as-a-Judge 等多种评分方式,适应不同科学任务的特性。

报告与存储层 (Report & Storage Layer): 确保评测过程的全透明记录,支持生成 CSV/JSON 格式的详细榜单报告。

评测洞察:通用强模型的“阿喀琉斯之踵”

基于SciEvalKit,科研团队对当前主流的闭源及开源模型进行了全方位评测,发现了一些值得深思的现象:

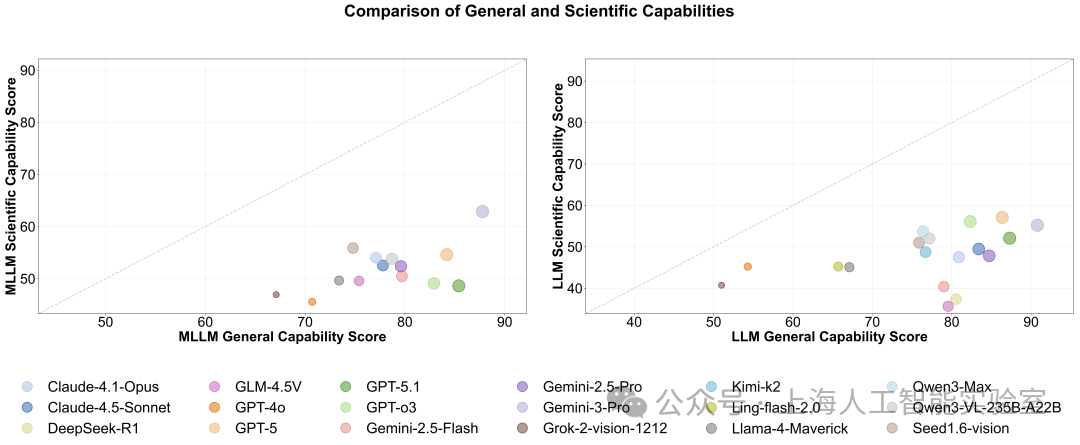

科学与通用能力之间存在“剪刀差”

尽管Gemini 3 Pro等前沿模型在通用任务上得分接近90分,但一旦进入严谨的科学场景,其得分便下降至60分以下。这表明通用的指令微调还不足以应对专家级的科学需求。

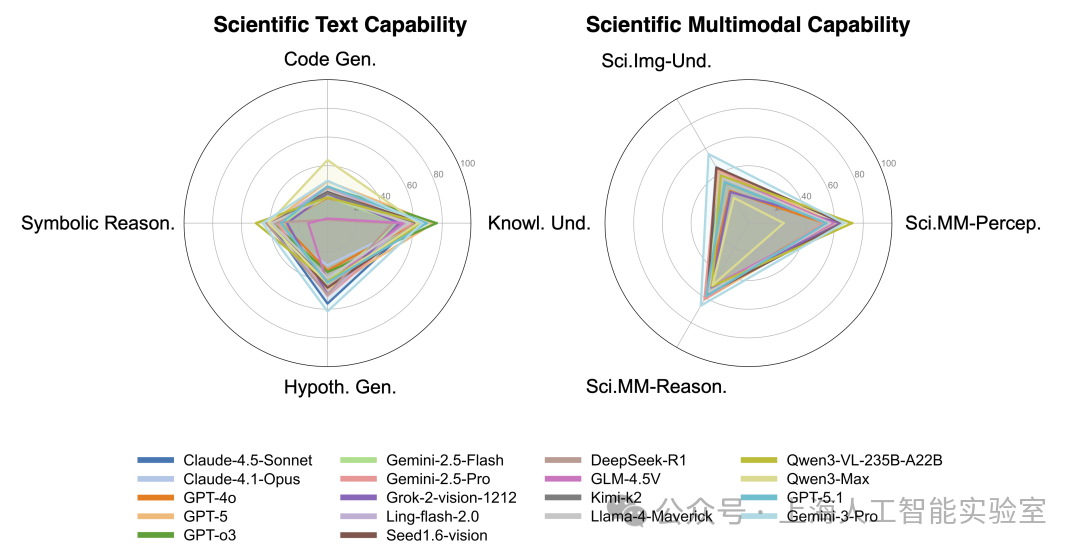

代码生成能力是短板

科学代码生成是所有评估模型中最薄弱的能力。这表明目前的大语言模型在将科学逻辑转化为可运行代码方面仍有巨大的提升空间。

Gemini 3 Pro遥遥领先,GPT 5.1略显平庸

Gemini 3 Pro不仅通用能力达到顶级水平,更在科学能力展现领先表现。作为GPT系列的最新旗舰模型,GPT 5.1在各方面能力“不升反降”。同时开源模型如Qwen3-VL-235B-A22B,能力不容小觑。