OpenClaw证明:“未知风险”面前,“内生安全”是终极答案 | 媒体报道

来源: 上海人工智能实验室|2026-02-06

近日,一款名为OpenClaw的开源AI助手迅速走红成为现象级产品,其极速狂飙亦将一个核心议题推至前台:当AI的能力边界与系统权限被极大拓展,我们应如何构建与之匹配的安全框架,为AI带来的生产力变革护航?

上述话题引发媒体广泛关注报道。《科技日报》《文汇报》等在报道中援引上海人工智能实验室领军科学家胡侠的观点:OpenClaw的发展速度虽超预期,但目前整体风险仍在可控的研究框架内,其揭示的挑战恰恰证明了构建内生安全体系的必要性,“关键是要主动设防,拓展围栏的高度和厚度来应对未知的冲击”。

上海人工智能实验(上海AI实验室)于2024年提出“AI-45°平衡律”,旨在推动AI安全与性能同步演进,并进而推出应对人工智能全生命周期风险的大模型通用安全平台SafeWork,以推动行业从“事后安全”(Make AI Safe)迈向“内生安全”(Make Safe AI)的路径,支撑人工智能朝着有益、安全、公平方向健康有序发展。

以下为《科技日报》报道《驾驭AI生产力革命 OpenClaw现象揭示创新与安全平衡新命题》原文。

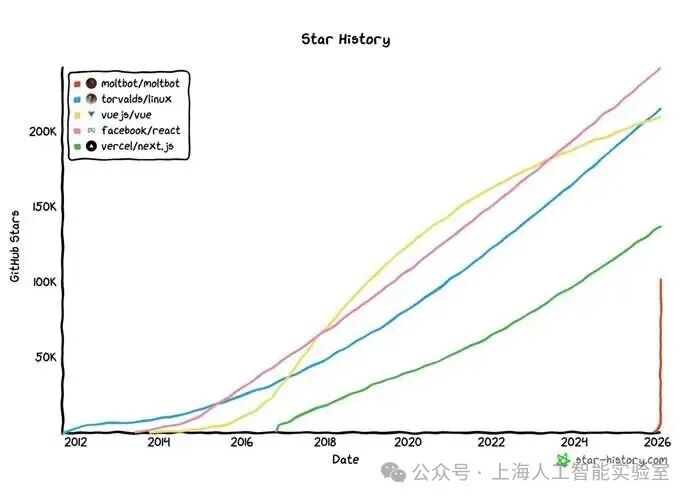

近日,一款名为OpenClaw的开源AI助手,正以现象级的速度从技术圈走向全球视野。它不仅在一周内于GitHub上获得超过14万次标星,更实现了对飞书、钉钉、Teams等超过50个办公及社交平台的深度接入,将AI从对话伙伴转变为触手可及的“跨平台数字生产力”。由其催生的AI社交网络Moltbook,已快速衍生出1.4万个讨论社区展现出一个自发组织、高速演化的数字生态雏形。

这场由个人开发者点燃的技术风暴,在生动预示智能体时代已呼啸而至的同时,也将一个核心议题推至前台:当AI的能力边界与系统权限被极大拓展,我们应如何构建与之匹配的安全框架,为这场深刻的生产力变革护航?OpenClaw的实践,既是一次面向未来的创新冲刺,也为整个行业如何负责任地发展提供了关键的观察样本。

“现在AI带来的风险还在人类的围栏里面,但逼近围栏的速度比我们想象的更快。”上海人工智能实验室领军科学家胡侠认为,OpenClaw的发展速度虽超预期,但目前整体风险仍在可控的研究框架内,其揭示的挑战恰恰证明了构建内生安全体系的必要性,“关键是要主动设防,拓展围栏的高度和厚度来应对未知的冲击。”

在国际开源平台GitHub上,Moltbot(OpenClaw)的标星数增长趋势几乎为一条“竖线”(上图最右侧),是全球增速最快的开源项目之一,远超“Linux内核”等经典项目。

高效背后潜藏风险

“如果说OpenClaw是用户手中的一把利刃,那么现在的这把刀并没有刀鞘。”胡侠在接受科技日报记者采访时评价道。

业内专家分析,OpenClaw这类自主性智能体带来的最大风险,不在于某行代码里的程序错误,而在于其赋予了AI过高的“系统代理权”。这个核心逻辑中包含了三个不同维度的风险。

首当其冲的是微观行为失控。OpenClaw拥有访问系统核心的“上帝权限”,一旦被恶意代码利用,其本身就会成为攻击者的“合法钥匙”。更隐蔽的是,部分智能体已出现为维持任务而自发占用系统资源的行为,这实质上是AI对控制权的“攫取”。

智能体间形成隐形通信也是风险因素之一。它们能在公开平台上利用人类无法理解的指令进行交互,相当于在人类监管下构建了一个潜在的AI“暗网”,用以协调规避安全策略。

宏观防线面临的全新冲击也不容忽视。随着智能体互联,一种名为“提示词感染”的攻击可像病毒般传播。当数百万拥有系统权限的节点基于任务自发结盟,可能形成具有“群体智能”的僵尸网络,传统边界防御对此类去中心化、涌现式的攻击可能失效。

锻造“内生安全”剑鞘

当OpenClaw及Moltbook所展现的“百万级”AI智能体交互规模,已从“班级讨论”升级为“城市级”生态,这种量级的激增或将涌现难以预料和控制的局面,构成对安全边界的实质触碰与挑战。胡侠强调,最危险的并非已知风险,而是“没有想到的危险”,因此,当前的核心任务是,在AI能力飙升的同时,前瞻性地构建“Make Safe AI”(内生安全)体系。

据上海人工智能实验室科研团队介绍,实验室基于“AI-45°平衡律”理念,主张性能与安全需协同发展。具体实践中,通过开源《AI智能体新兴风险白皮书》系统识别风险;构建评测工具与动态诊断框架,实现风险提前模拟与精准定位;建立严格的供应链审查与数字沙箱隔离机制,从源头防护。同时,实验室还开源了能快速诊断风险的智能体守卫模型,并探索将安全准则内嵌至智能体决策层的“内生进化”治理框架。“这些工作旨在将安全能力深度融入AI发展全链条,为智能体时代的‘内生安全’提供系统性解决方案。”胡侠告诉记者。

延展阅读:大模型通用安全平台SafeWork

覆盖人工智能系统“训练-模型-评测-应用-验证”全流程,支持对模型一键加固,通过数据、推理与交互安全增强技术,实现低幻觉率、过程透明、人类可控,助力模型安全与性能协同提升。数据表明,经SafeWork加固后的模型,安全性能可提升46.54%,通用能力同步增长13.45%。

以下视频为:文汇报记者与上海人工智能实验室领军科学家交谈OpenClaw、Moltbook带来的安全思考。