书生·万象3.5发布,通用能力、推理能力与部署效率全面升级

来源:上海人工智能实验室| 2025-09-03

近日,上海人工智能实验室(上海AI实验室)开源通用多模态大模型书生·万象3.5(InternVL3.5),其推理能力、部署效率与通用能力全面升级。

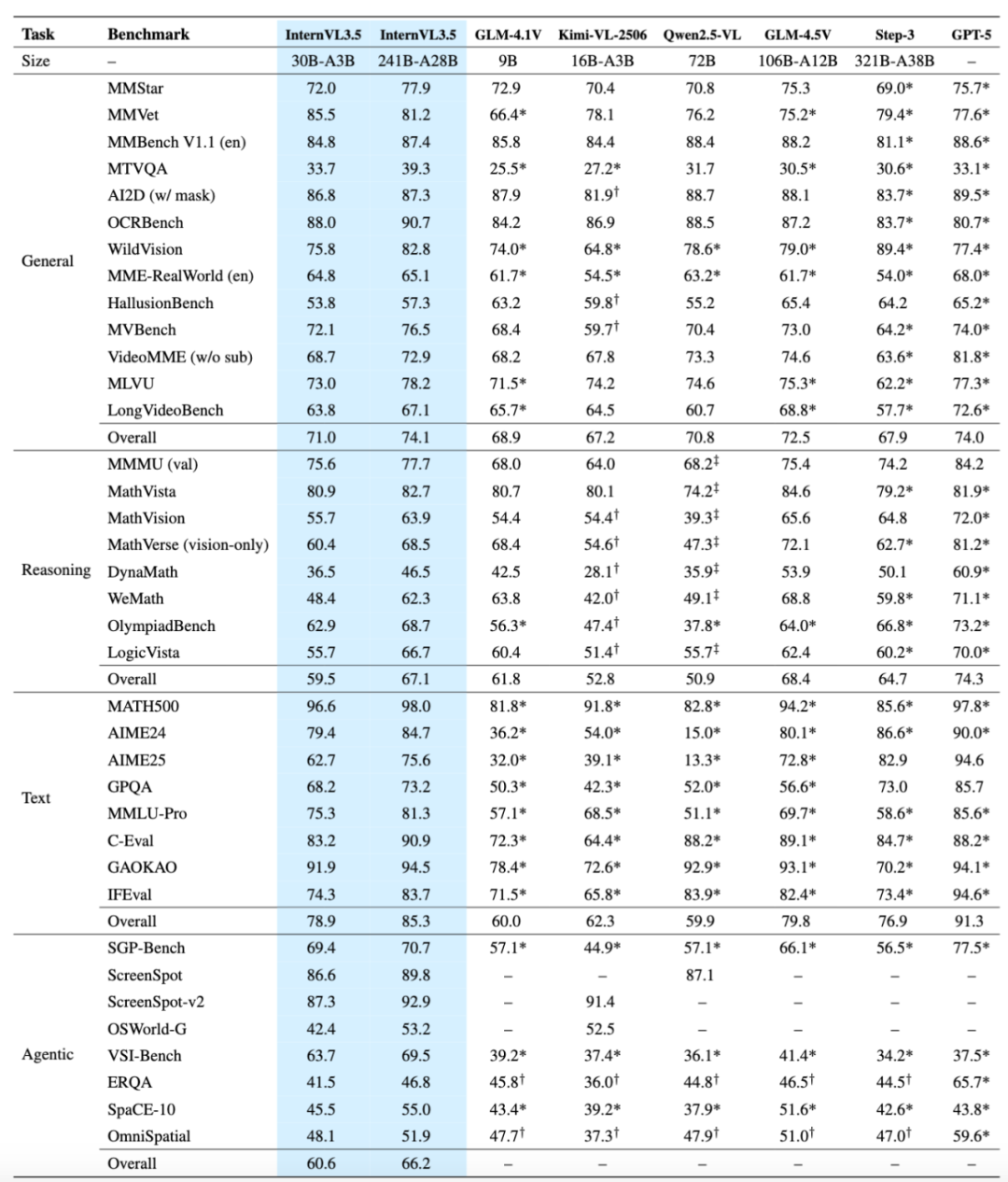

InternVL3.5本次开源有9种尺寸的模型,参数涵盖10亿-2410亿,可满足各场景需求。其中,旗舰模型InternVL3.5-241B-A28B在多学科推理基准MMMU中获77.7分,为开源模型中最高分;多模态通用感知能力超越GPT-5,文本能力领跑主流开源多模态大模型。与InternVL3.0相比,InternVL3.5在图形用户界面(GUI)智能体、具身空间感知、矢量图像理解与生成等多种特色任务上实现显著提升。

作为上海AI实验室书生大模型体系的重要组成部分,InternVL聚焦视觉模型技术的创新与突破,凭借领先性能和低算力消耗的优势,InternVL全系列全网下载量已突破2300万次。

技术报告链接:https://huggingface.co/papers/2508.18265

代码开源/模型使用方法:https://github.com/OpenGVLab/InternVL

模型地址:https://huggingface.co/OpenGVLab/InternVL3_5-241B-A28B

在线体验链接:https://chat.intern-ai.org.cn/

全场景能力提升,实现从“理解”到“行动”的跨越

本次升级,上海AI实验室研究团队重点强化了InternVL3.5面向实际应用的智能体与文本思考能力,在GUI交互、具身空间推理和矢量图形处理等多个关键场景实现从“理解”到“行动”的跨越,并得到多项权威评测验证。

GUI交互部分,InternVL3.5在ScreenSpot-v2元素定位任务以92.9分超越同类模型,同时支持Windows/Ubuntu自动化操作,并在WindowsAgentArena任务大幅领先Claude-3.7-Sonnet。

在具身智能体测试中,InternVL3.5表现出理解物理空间关系并规划导航路径的能力,在VSI-Bench以69.5分超过Gemini-2.5-Pro。

在矢量图形理解与生成方面,InternVL3.5在SGP-Bench以70.7分刷新开源纪录,生成任务FID值也优于GPT-4o和Claude-3.7-Sonnet。

不只是评测成绩亮眼,InternVL3.5在智能办公、机器人训练、AI for Science等实际场景中也展示出强劲实力。具体实例如下:

GUI智能体

InternVL3.5可跨Windows、Mac、Ubuntu、Android等多个平台,精确识别界面元素并自主执行鼠标、键盘操作,实现恢复已删除文件、导出PDF、邮件添加附件等任务的自动化,有效提升办公效率。

具身空间推理InternVL3.5具备更强的grounding能力,可以泛化到全新的复杂大量小样本的具身场景,配合抓取算法,支持可泛化的长程物体抓取操作,助力机器人更高效地完成物品识别、路径规划与物理交互。

(视频由录制视角记录)

矢量图生成与编辑

基于InternVL3.5 8B专有SVG模型,用户能够在发出自然语言指令后,让模型生成或编辑SVG矢量图形。本项能力可有效应用于网页图形生成与工程图纸解析等专业场景。

示例1:根据文字指令生成矢量图文件指令示例:

一个带有黄色和橙色三角形切面的几何钻石形状;

一个带有扳手和锤子图标的红色工具箱;

一个带有深色底座和屏幕的蓝色电脑显示器图标。

效果:

示例2:根据文字指令编辑矢量图文件

指令示例:在番茄的脸上涂一滴眼泪。

输入:

输出:

通用推理能力

从数学物理考研题到国考图形推理逻辑测试,再到桌游策略推演,InternVL3.5以领先的通用推理能力实现多场景认知迁移。例如,在AI for Science场景中,模型可协助科研人员进行分子结构解析、材料性能预测等复杂推导。

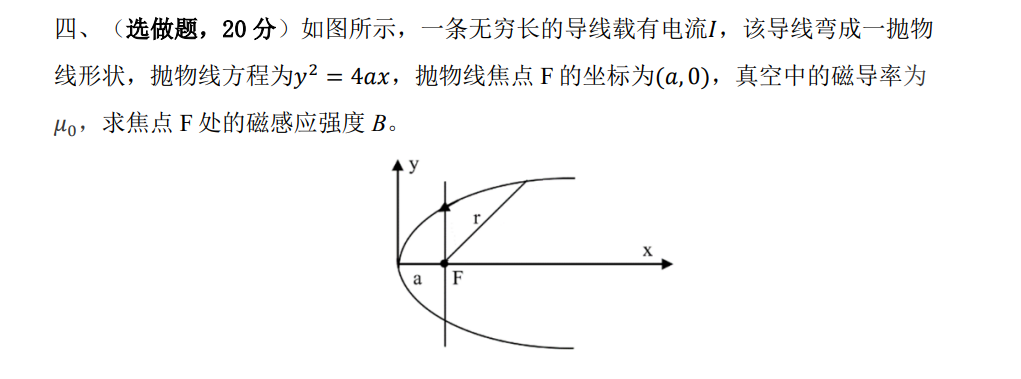

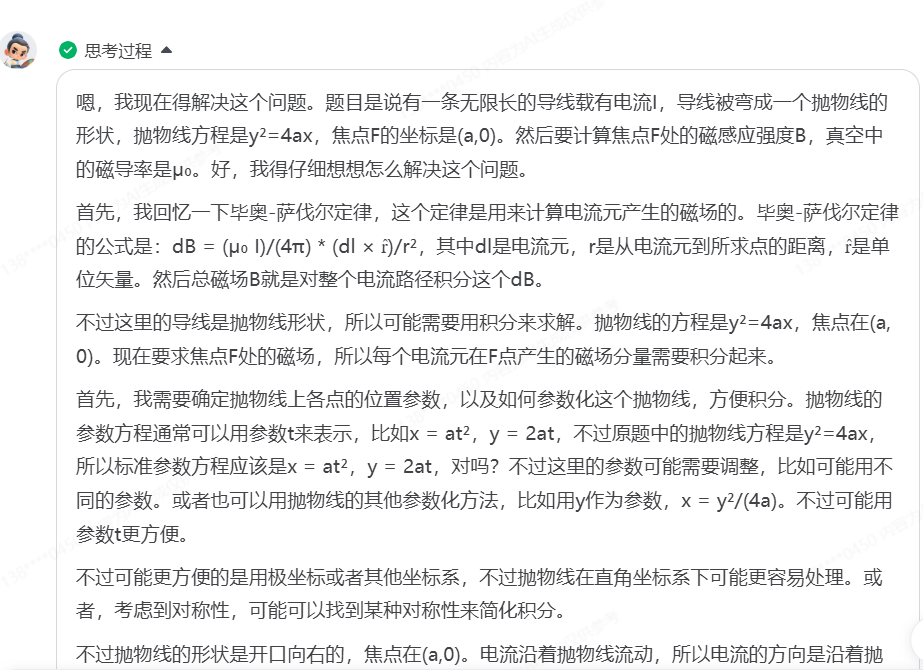

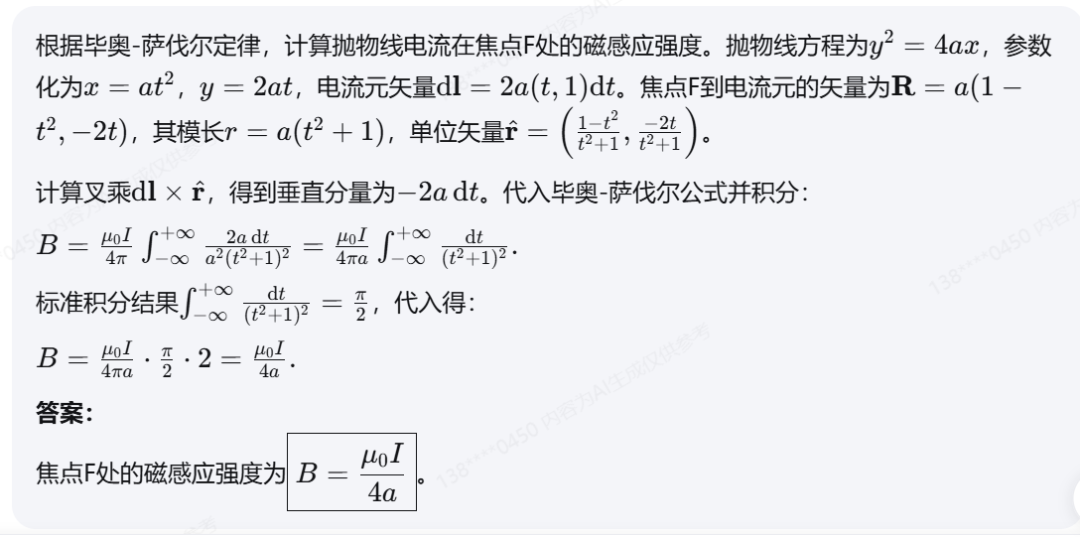

示例1:数学物理考研题

问题

解答这道题

回答

(中间思考过程略)

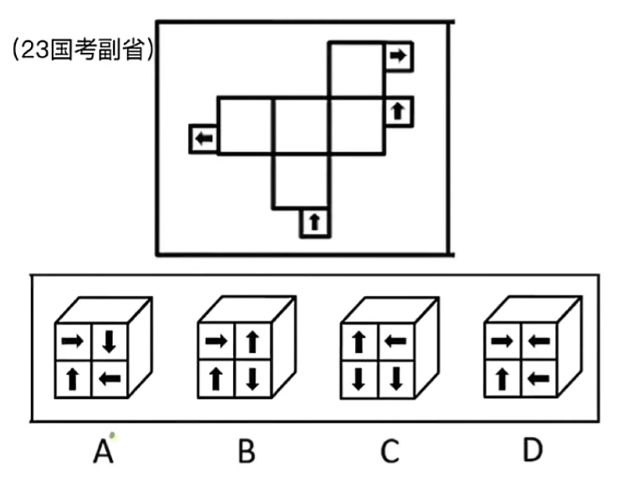

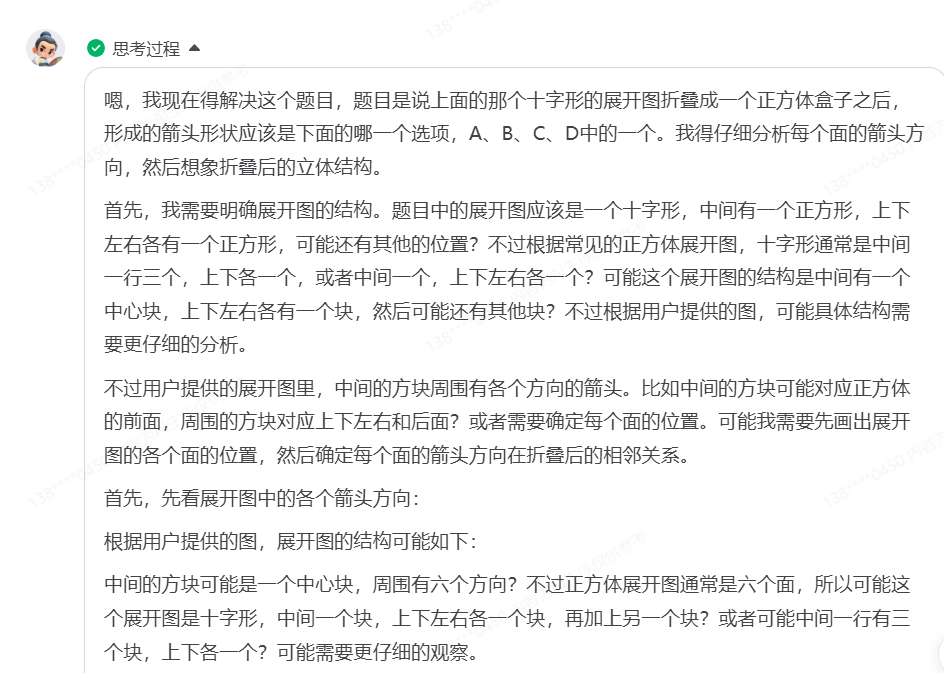

示例2:国考图形推理逻辑测试

问题

上面大方框中的纸折叠成一个正方形盒子之后,形成的箭头的形状,应该是下面A B C D中的哪个

回答

(中间思考过程略)

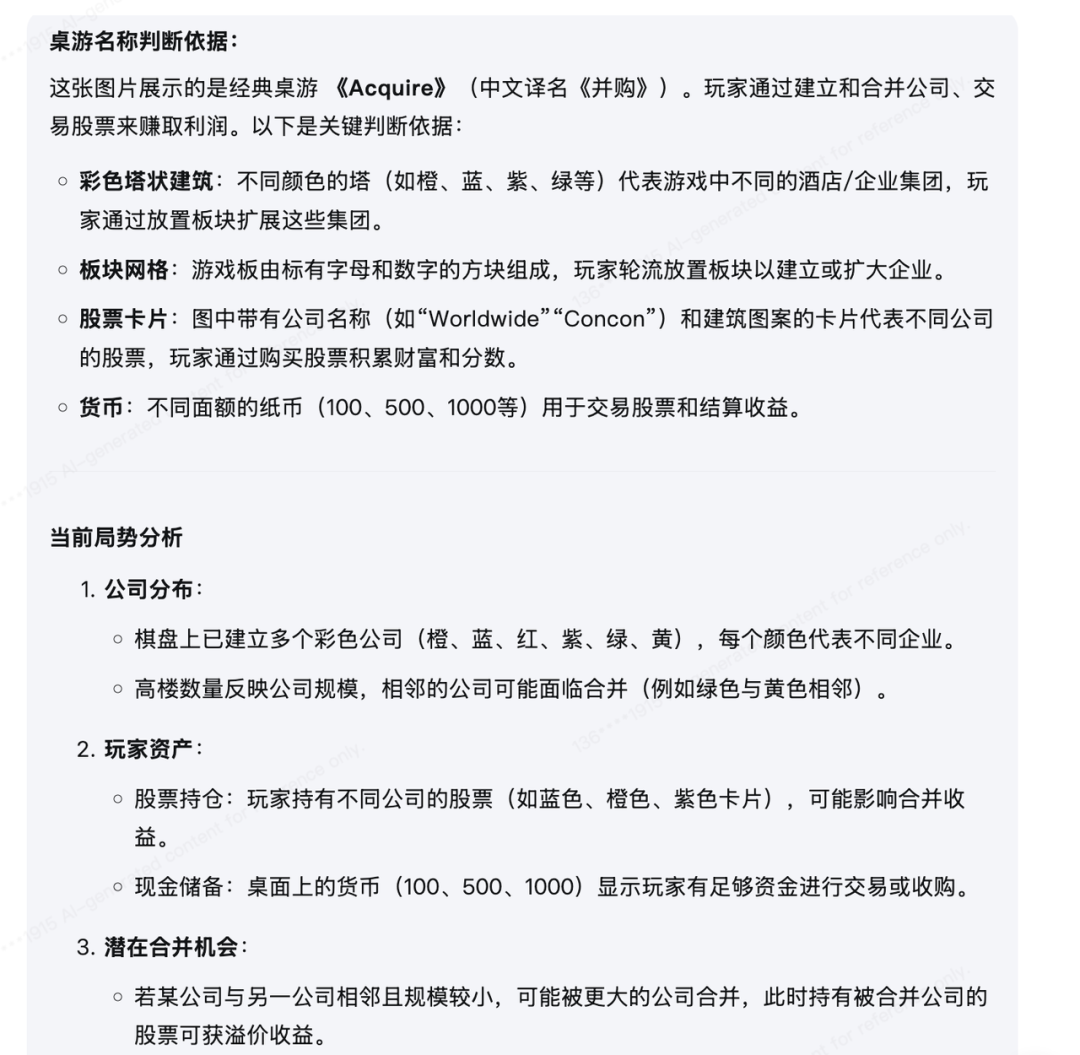

示例3:桌游策略推演问题

这是什么桌游?给出判断依据,分析场上局势,给出下一步的行动建议

回答

(中间思考过程略)

InternVL3.5实现全场景能力提升并非源于单一维度的突破,而是架构、训练、部署“三位一体”的系统性优化的成果。

引入视觉分辨率路由,破解视觉模块效率瓶颈

在架构方面,InternVL3.5的基础架构遵循了业界成熟的 “ViT-MLP-LLM”范式,并创新提出视觉分辨率路由(Visual Resolution Router,ViR),有效解决多模态模型的视觉模块因高分辨率输入导致的效率瓶颈这一普遍性难题。

ViR的创新之处在于它能基于图像语义内容进行自适应计算。在实际工作中,ViR基于视觉一致性学习(ViCO)智能化评估每个图像块的语义丰富度,并根据评估结果,选择不同的压缩路径:对于语义密集区域(如文字、图表),ViR会将其路由至高分辨率通路(保留更多Token);而对于语义信息较少的背景区域,则路由至低分辨率通路(保留更少Token)。实测数据显示,轻量化的InternVL3.5-Flash在将视觉序列长度减少50%的情况下,仍能保持接近100%的性能水平;在DocVQA、OCRBench等高分辨率任务上,InternVL3.5在保持高性能的同时推理速度显著提升。

创新多模态强化学习框架,训练效率和模型性能双提升

传统强化学习在多模态模型中常面临“效率低”或“性能上限低”的两难困境:在线强化学习效果好,但通常计算成本较高且训练过程不稳定;离线强化学习训练快,但其性能上限往往受到离线数据质量的限制。

因此,研究团队提出了级联式强化学习(Cascade Reinforcement Learning,Cascade RL)框架,通过“离线预热-在线精调”两个阶段,逐步提升多模态模型的推理能力。通过Cascade RL,InternVL3.5将离线强化学习的高效率、稳定性和在线强化学习的高性能潜力相结合,构建了一条高效、稳定且可扩展的推理能力提升路径:在离线强化学习阶段,采用混合偏好优化(MPO)算法快速让模型达到基础推理水平,为后续训练提供高质量输出样本;在在线强化学习阶段,主要基于GSPO算法,以模型自身生成的样本为基础,动态调整输出分布,无需依赖外部参考模型,进一步提升其推理的上限。

对比单阶段强化学习,级联式强化学习仅通过50%的GPU训练时间即可达到更优的综合性能,同时在1B到241B全参数规模中均实现稳定性能增益,实现InternVL3.5全系列模型推理性能相较上一代平均提升16.0分。其中,InternVL3.5-241B-A28B综合推理性能达到66.9分,超越上一代模型的54.6分以及Claude-3.7-Sonnet的53.9分,在数学推理、逻辑推理等复杂任务中表现更为突出。

提出高效部署方案,实现超4倍的推理加速

在传统的多模态模型推理部署方案中,视觉编码器(如 ViT)和语言模型(LLM)通常串行执行,部署在同一个或同一组 GPU 上。然而,这两部分的计算特性截然不同,视觉编码器的计算会阻塞语言模型的执行,导致GPU资源利用率低下。

基于这一背景,研究团队提出视觉-语言解耦部署(Decoupled Vision-Language Deployment,DvD)方案:将视觉编码器(ViT+MLP)与语言模型(LLM)分置于不同GPU,并结合BF16精度特征传输与异步流水线设计,使视觉计算与语言生成能够并行执行。

DvD带来了显著的推理加速,实测数据显示:InternVL3.5-38B模型在处理1344x1344分辨率的图像时,若仅使用DvD可以将吞吐量提升1.97倍;若结合使用DvD与ViR,加速效果更为显著,最高可达4.05倍。这一突破不仅意味着性能上的飞跃,更成为推动高分辨率、强推理能力的多模态大模型在实际场景中落地应用的关键工程成果。