TTRL:“经验时代”强化学习的展望

来源:上海人工智能实验室| 2025-05-23

2025年4月12日,Google DeepMind 强化学习团队副总裁David Silver与图灵奖得主、强化学习之父Richard Sutton共同发表了题为《Welcome to the Era of Experience》(欢迎来到经验时代)的文章 [1]。文章指出,未来人工智能的发展将经历重要的范式转变:从单纯模仿人类转向自主创造经验。这意味着人工智能模型将摆脱对人类知识的完全依赖,不再只是人类知识的被动消费者,成为主动探索环境、自主学习的主体。

不谋而合地,上海人工智能实验室(上海AI实验室)也对这一全新范式提前布局并展开探索。4月22日,实验室与清华大学联合提出“测试时强化学习”(Test-Time Reinforcement Learning, TTRL)框架,正是在“人工智能通过体验展开主动探索和自主进化”上的积极尝试。这种范式的转变有望显著提升人工智能的泛化与自主创新能力,使人工智能突破现有人类知识的限制,在未知领域实现自主创新。

· 论文:https://arxiv.org/abs/2504.16084

· 代码:https://github.com/PRIME-RL/TTRL

欢迎来到经验时代

“我们所期望的是一台能够从经验中学习的机器。”

——艾伦·图灵,1947年伦敦演讲(关于“计算智能”)

过去十年,从人类数据进行监督学习的范式正逐渐逼近其性能极限,人工智能迈向真正的自主学习成为了核心挑战。

David Silver 和 Richard Sutton在《Welcome to the Era of Experience》中指出,人工智能的发展正处于一个关键的转折点:未来将从监督学习转向基于经验的自主学习。人工智能系统将通过自身与环境的交互持续积累经验,从而摆脱对静态数据的依赖,主动探索未知环境,不断优化和提升自身能力。这种方式能够提升人工智能模型的泛化能力,并在缺乏人类经验的数据领域实现创新与突破。具体而言,人工智能将通过“亲自经历”世界的方式理解和适应世界,实现自主探索。这种持续进化的经验积累过程,有可能带来远超当前水平的性能提升。相应地,在上海AI实验室的“通专融合” [2]发展框架中,基础模型层着力构建高效的泛化能力,这与AI通过广泛经验习得通用理解的层面相对应;融合协同层则强调通用能力与专业知识的有机结合;而自主进化与交互层则聚焦于具身自主学习。

强化学习和测试时扩展

强化学习——驱动模型主动学习的天然路径

2016年3月,AlphaGo 以4:1击败韩国九段棋手李世石,震惊世界。

2025年伊始,强化学习再度成为全球人工智能领域的关注焦点。无论是图灵奖授予了强化学习,还是由 DeepSeek 的 R1 与 OpenAI 的 o1 引发的推理模型发展,都预示着:强化学习正在逐步打破过去监督学习和无监督学习主导的格局,并被认为是通向通用人工智能(AGI)的关键路径。

这其中的核心原因是:大语言模型与大规模强化学习的结合被证明可以诱导复杂的推理行为,如自我验证和迭代优化,从而显著提升模型在推理任务中的表现。

更为重要的是,强化学习目前是最直接支持模型通过交互实现自主体验和主动学习的框架。它为构建具备持续适应与演化能力的人工智能提供了必要的理论支撑与技术手段。

因此我们认为,强化学习将在推动人工智能从被动学习向主动学习范式转变的过程中发挥核心作用。

测试时扩展——推理与训练的协同进化

继续深入思考的话,这背后更深刻的范式转变其实发生在测试时扩展(Test-Time Scaling,TTS)。

以 DeepSeek 的 R1 和 OpenAI 的 o1 模型为例,这些系统的强化学习训练本质上是通过引导模型在推理过程中生成更长的思维链(Chain-of-Thought, CoT),从而增加推理阶段的计算量,实现输出分布的动态优化。这种机制有效拓展了 TTS 的能力边界。

传统意义上的 TTS,主要指的是测试时推理(Test-Time Inference, TTI)方法,典型手段包括并行采样、循序修订等解码策略 [3]。这些策略通过增加测试阶段的计算开销,在不更改模型参数的前提下,优化解码过程以生成更高质量的输出。

然而,一个值得进一步探讨的问题是:TTS 是否只能依赖增加模型推理解码的计算量来实现?

在测试时调整模型参数的方法过去在测试时训练(Test-Time Training, TTT)这一领域被广泛研究。因此,我们的另一个关键思考在于:TTS 不应局限于 TTI,而应扩展为涵盖 TTI 与 TTT 的统一框架。TTT 本质上是通过调整模型参数的方式增加计算量,从而实现 TTS 的另一种可行方式。

研究团队希望通过这一拓展性视角,推动人工智能在未知任务与环境中的适应性与创新能力,实现“通过经验进化”的学习机制。

测试时强化学习:TTRL

我们正在从纯粹依赖人类标注数据的训练范式,转向一个模型能够通过体验标注数据自训练的新时代。

为探索人工智能自主进化的可能路径,实验室和清华大学联合提出了测试时强化学习(TTRL)框架,填补了人工智能模型通过强化学习在无监督数据上自进化的研究空白。

动机:拥抱“RL版AI自进化”

有标注数据上的强化学习至关重要,DeepSeek R1 和 OpenAI o1 的巨大成功无不说明了这一点。然而现实中层出不穷且亟待解决的复杂任务持续挑战着现有模型的极限。单纯扩展(Scaling)数据和计算资源来解决这些问题不仅成本高昂,还面临性能提升的瓶颈。

正如《Welcome to the Era of Experience》所指出的,通过自主经验学习将是人工智能发展的新路径。结合RL最近的巨大成功,很自然地让人想到,能否以RL的方式实现人工智能模型在无标注数据上的自进化?在无标注数据上基于强化学习的自体验 (Rollout)→自奖励 (Reward)→自强化 (Update)的动态循环,恰好提供了突破现有瓶颈的有效方案,也促进了人工智能研究范式向“经验时代”的转变。

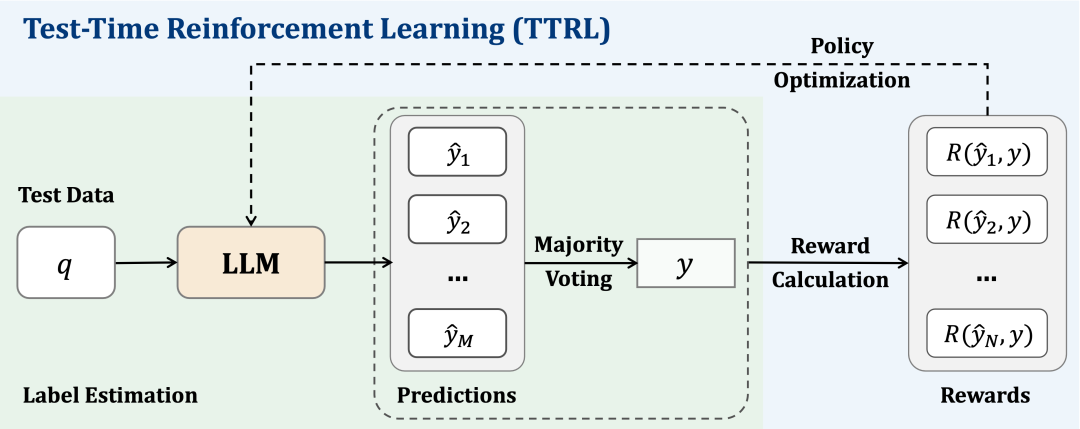

TTRL应运而生:TTRL尝试在无监督的测试数据上通过强化学习实时调整模型参数,实现人工智能模型在测试阶段的自主进化。TTRL与已有的有标注数据RL的主流范式并不冲突,并且进一步结合TTRL以实现泛化和扩大训练还会带来更大的提升。问题是,在没有标签的情况下如何获取有效的奖励信号?本研究发现,利用简单的测试时扩展方法,如多数投票(Majority Voting)即可提供足够可靠的标签估计,从而支持稳定高效的强化学习。

具体来说,TTRL通过多数投票来估计标签,进一步使用该伪标签计算基于规则的奖励,最终实现无监督设置下的强化学习。

"A natural path for advancing reasoning in the wild."

“在真实世界中推进推理能力发展的自然路径。”

实验:高效,通用,可扩展,泛化,动态进化

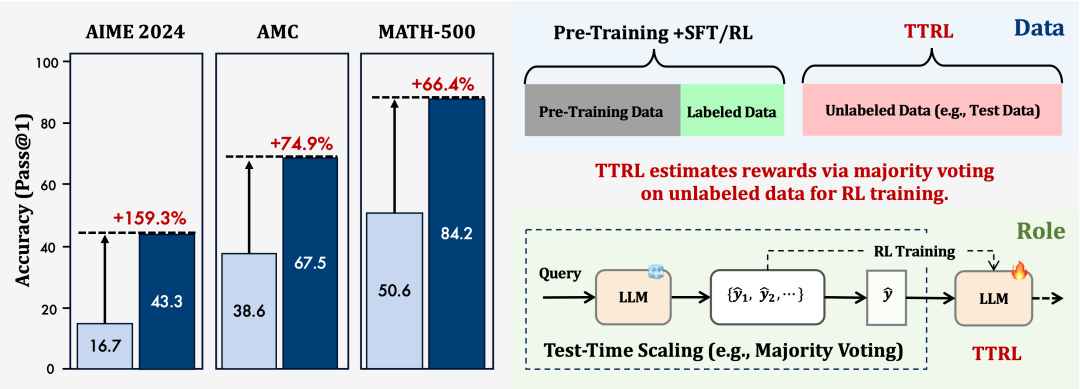

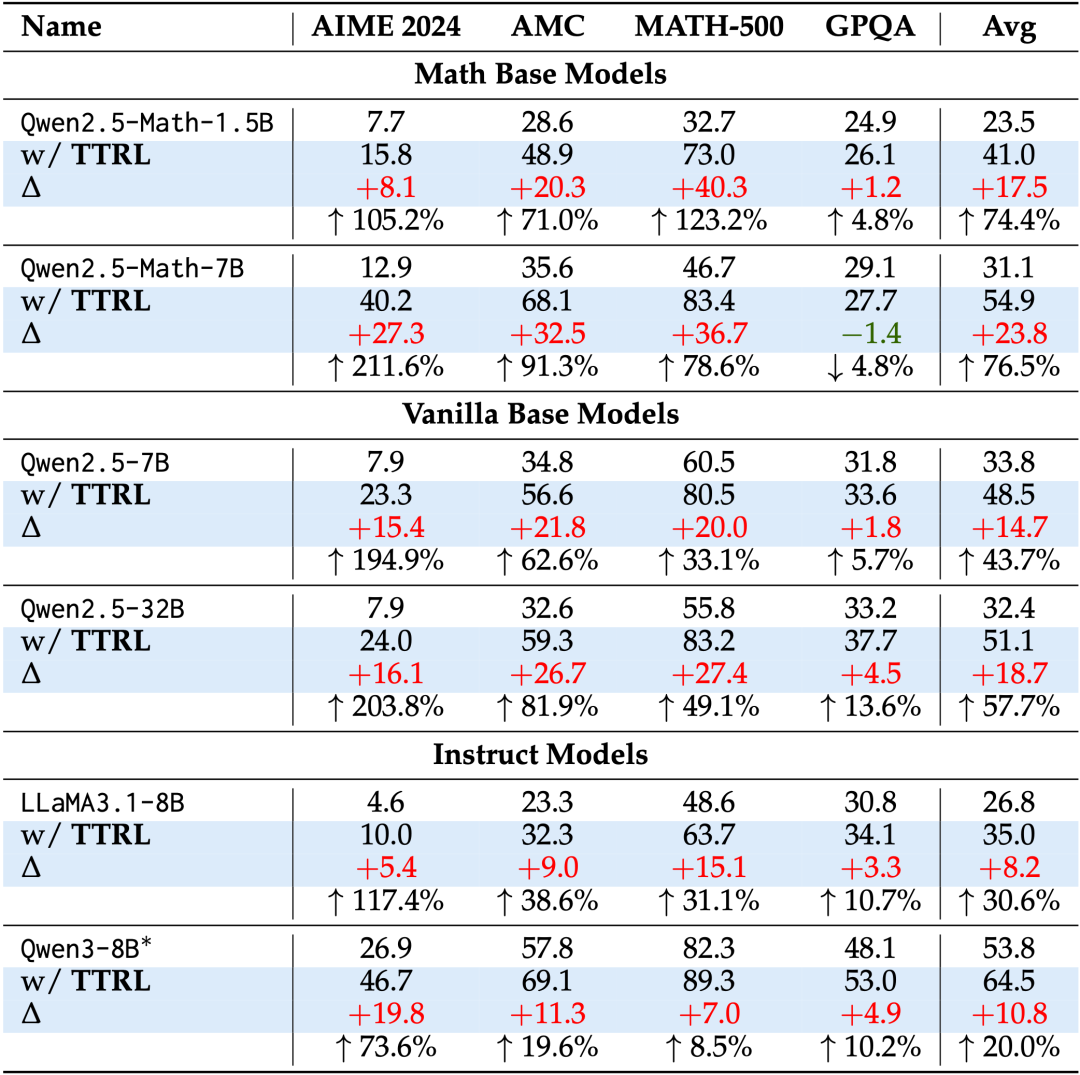

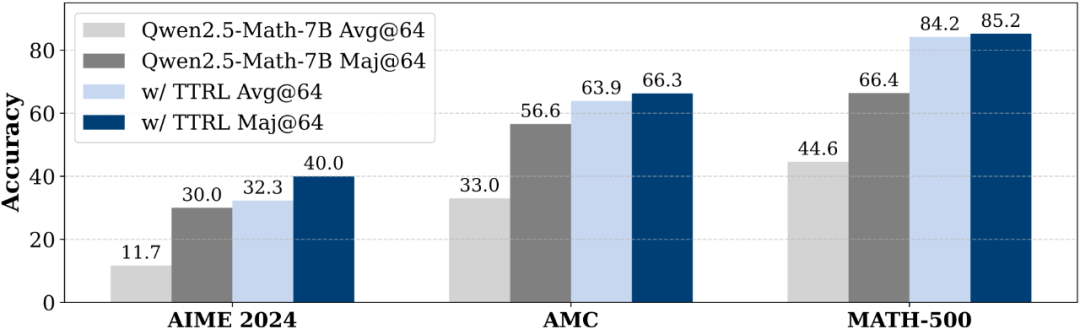

高效,通用:TTRL在不依赖人工标注数据的前提下,仅通过模型自身的自进化实现了巨大提升,并能推广到广泛的任务。将TTRL应用于包括4个系列、2种类型和3级规模的6个模型上后,在4个高度挑战性的基准任务上均可以观察到显著的性能提升。例如,在Qwen2.5-Math-7B模型上,AIME 2024测试的得分提升高达27.3分(211%);在仅有1.5B参数规模的小模型上,TTRL在MATH-500基准上实现了40.3分的提升。

可扩展:随着模型规模的提升(如1.5B到7B,7B到32B),TTRL带来的提升幅度展现出增长的趋势。这一趋势可能得益于更大的模型在“自我改进”过程中能够生成更准确、更稳定的多数投票信号,从而有效引导无标注数据上的学习过程,进一步提升模型表现。

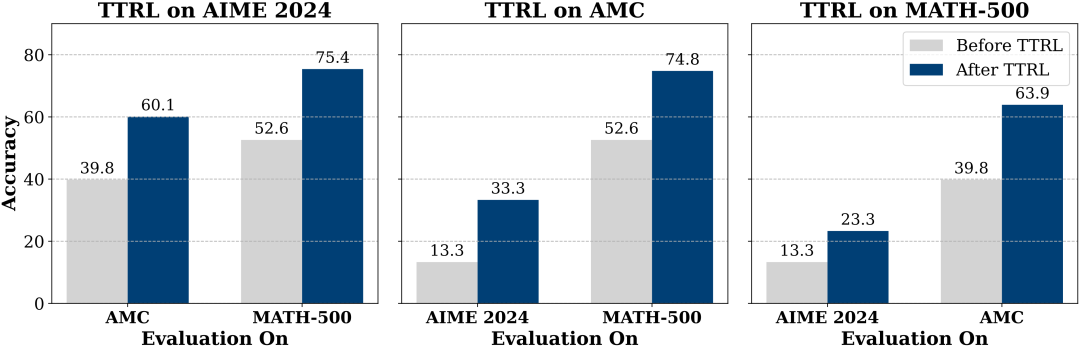

泛化:一个直觉上的担忧是:TTRL是否会对特定的测试数据产生过拟合?然而实验结果表明,即便TTRL仅在某一测试集上进行应用,其优化效果同样可以泛化至其他任务和数据集,带来显著的性能提升。这表明,TTRL本质上是在推动模型整体能力的自我进化,而非简单针对特定测试数据的拟合,具备良好的泛化性。

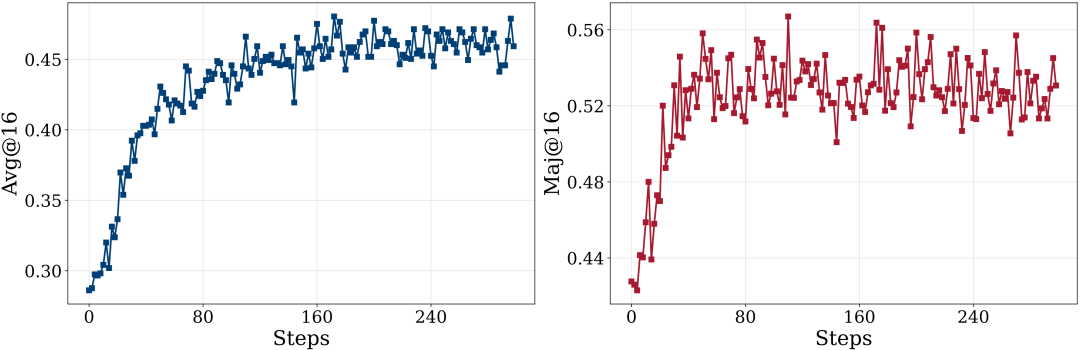

动态进化:TTRL具有可持续的、动态的“自我进化”机制。在训练过程中,avg@16与maj@16指标展现出同步上升的趋势,体现出模型能力与监督信号之间的双向正反馈关系。具体而言,模型能力的提升能够带来更高质量的监督信号,而更优的监督信号又反过来进一步促进模型能力的增强,形成持续自我强化的正向循环进化过程。

性能上限:TTRL能表现多好?

得益于TTRL“动态”和“强化学习”的特性,TTRL展现出了突破上限的可持续进化:

青出于蓝而胜于蓝,超越自身监督信号的性能:直观上看,初始模型的多数投票性能(maj@n)可以被视为TTRL性能的一个上限,因为这是其训练初期所依赖的监督信号,TTRL的表现可能会逐步逼近这一水平。并且初始模型的多数投票性能其实就是传统的基于有监督训练的自训练方法的性能上限 [4]。但实际上,TTRL在多个任务上都展现出了突破上限的表现,性能超过了初始模型的多数投票分数,最高实现了超过20分的提升。这说明其通过一个动态自强化的过程实现了高效的自举。AI 左脚踩右脚能否登天?虽然无法100%确定,但这种突破上限的动态自进化过程,表明这是有希望的。

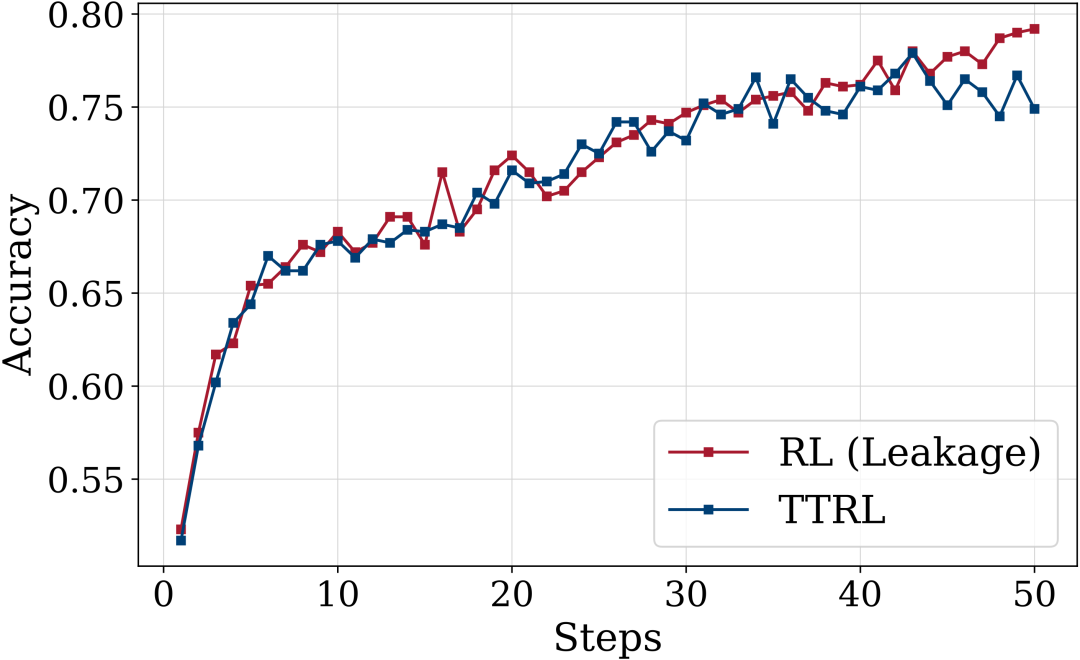

无师自通,性能直逼“开卷考试”:在完全不依赖标签数据的前提下,TTRL 的表现几乎追平了在测试集上训练的性能(本质上是在同一数据集上训练+测试,由于产生了信息泄露,因此是一种作弊的有监督设置)。这一结果令人惊讶,不仅表明其自我学习能力已可与传统有监督方法相媲美,甚至在某些场景下接近了依赖信息泄露的“作弊式训练”所能达到的性能上限。

原理:为什么TTRL能奏效?

TTRL的“在线”学习特性是其突破性能上限的关键因素之一,但如果奖励不准确导致强化学习不稳定,TTRL同样不能奏效。研究团队在深入分析后,观察到了一个有趣的现象“Lucky Hit”,使得多数投票错误时仍然能提供可靠的奖励用于强化学习。

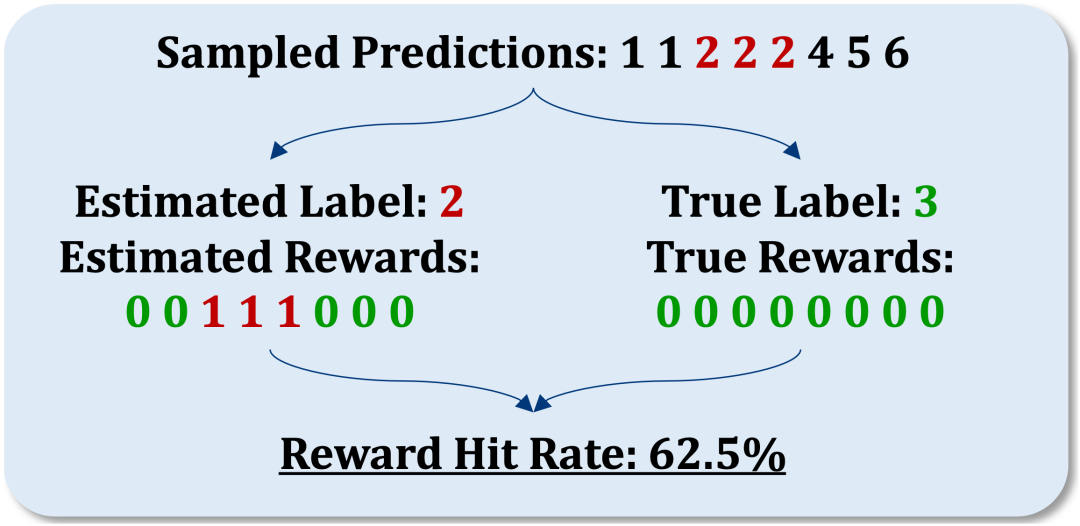

在 AIME 2024 这类高难度基准上,即便模型无法通过多数投票准确估计标签,TTRL 依然展现出令人印象深刻的提升。这背后的关键就在于强化学习中奖励的计算方式:对于数学任务,验证器是基于“对比机制”工作的,通过判断模型预测是否与给定标签一致来计算奖励。这种机制就引发了一个有趣的现象:“Lucky Hit”。图中展示了一个“Lucky Hit”的例子,尽管估计标签为 2,真实标签为 3,但只要模型预测不是 2 或者 3,就依然能收到正确的负向奖励信号,整体奖励准确率依然高达 62.5%。也就是说,即使估计的标签本身是错的,只要模型的预测结果与这个“错误标签”不同,系统就会给予负向的奖励,而这正是我们期望得到的正确奖励信号。这表明:有效的监督并不总是依赖于完全正确的标签估计,即使估计的标签是错误,只要它能够引导出正确的奖励信号,模型的训练就依然有效。

因此TTRL在 AIME 2024 上依然展现出了稳定且优异的表现的核心原因就在于其内在的机制:即使标签存在错误,仍然可以得到正确的奖励驱动模型朝着正确方向学习。这一特性在实际训练中发挥了关键作用。同时,奖励的密集性以及错误预测的分布特征等因素也进一步增强了这一效果,具体细节可参考原论文。

可以验证这一系列分析的一个实验观察是,在AIME 2024上,尽管标签估计的准确率仅为 16%,TTRL 最终获得的奖励准确率却高达 92%。这种高度准确的奖励信号,为无监督环境下的自我优化提供了可靠的基础。这一发现展示了 TTRL 在估计标签低正确率的条件下仍能有效学习的机制,也有力支持了其在减少人工标注依赖方面的潜力,进一步推动强化学习向大规模、无监督方向的持续扩展。

人工智能的发展正站在一个关键的转折点上。从模仿人类到通过经验自主进化,强化学习正在成为通向更高智能形态的关键方法。测试时强化学习(TTRL)作为实验室对这一范式转变的探索,展示了在无监督环境中实现自我进化的现实可能。

经验时代的到来,意味着人工智能模型将不再是规则的执行者,而将成为探索者与建构者。

一切刚刚开始。

参考文献

[1] Silver, David, and Richard S. Sutton. "Welcome to the era of experience." Google AI (2025).

[2] 周伯文. 以通专融合方式构建AGI——路径与关键问题[J]. 中国计算机学会通讯, 2025, 21(1): 54-62.

[3] Weng, Lilian. “Why We Think.” Lil’Log, 1 May 2025, https://lilianweng.github.io/posts/2025-05-01-thinking/.

[4] Huang, Jiaxin, et al. "Large language models can self-improve." arXiv preprint arXiv:2210.11610 (2022).